| IP | 服務器名 | 操作系統 | 服務 | 備注 |

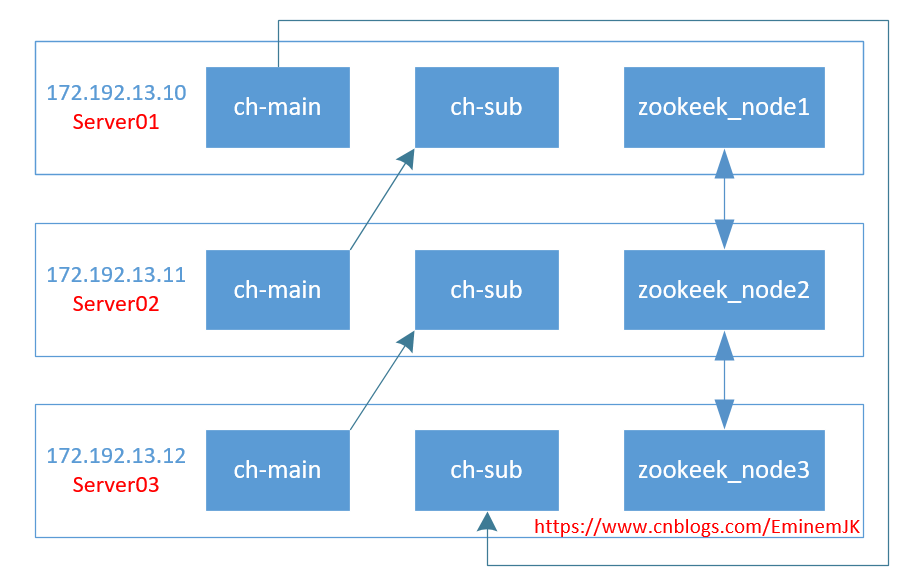

| 172.192.13.10 | server01 | Ubuntu20.04 | 兩個Clickhouse實例、Zookeeper |

CH實例1端口:tcp 9000, http 8123, 同步端口9009,MySQL 9004, 類型: 主分片1 CH實例2端口:tcp 9000, http 8124, 同步端口9010,MySQL 9005, 類型: server02的副本 |

| 172.192.13.11 | server02 | Ubuntu20.04 | 兩個Clickhouse實例、Zookeeper |

CH實例3端口:tcp 9000, http 8123, 同步端口9009,MySQL 9004, 類型: 主分片2 CH實例4端口:tcp 9000, http 8124, 同步端口9010,MySQL 9005, 類型: server03的副本 |

| 172.192.13.12 | server03 | Ubuntu20.04 | 兩個Clickhouse實例、Zookeeper |

CH實例5端口:tcp 9000, http 8123, 同步端口9009,MySQL 9004, 類型: 主分片3 CH實例6端口:tcp 9000, http 8124, 同步端口9010,MySQL 9005, 類型: server01的副本 |

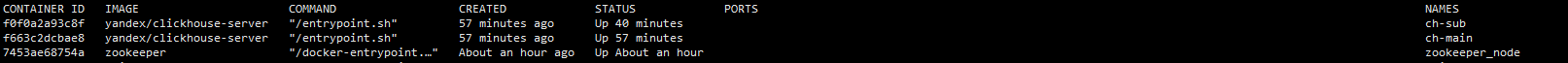

在每一臺服務上都安裝docker,docker里面分別安裝有3個服務:ch-main,ch-sub,zookeeper_node,如圖所示:

細心的已經看到,PORTS沒有映射關系,這里是使用Docker host網絡模式,模式簡單并且性能高,避免了很多容器間或跨服務器的通信問題,這個踩了很久。

1. 服務器環境配置

在每一臺服務器上執行:vim /etc/hosts,打開hosts之后新增配置:

172.192.13.10 server01 172.192.13.11 server02 172.192.13.12 server03

2.安裝docker

太簡單,略...

3.拉取clickhouse、zookeeper鏡像

太簡單,略...

在每個服務器上你想存放的位置,新建一個文件夾來存放zk的配置信息,這里是/usr/soft/zookeeper/,在每個服務器上依次運行以下啟動命令:

server01執行:

docker run -d -p 2181:2181 -p 2888:2888 -p 3888:3888 --name zookeeper_node --restart always \ -v /usr/soft/zookeeper/data:/data \ -v /usr/soft/zookeeper/datalog:/datalog \ -v /usr/soft/zookeeper/logs:/logs \ -v /usr/soft/zookeeper/conf:/conf \ --network host \ -e ZOO_MY_ID=1 zookeeper

server02執行:

docker run -d -p 2181:2181 -p 2888:2888 -p 3888:3888 --name zookeeper_node --restart always \ -v /usr/soft/zookeeper/data:/data \ -v /usr/soft/zookeeper/datalog:/datalog \ -v /usr/soft/zookeeper/logs:/logs \ -v /usr/soft/zookeeper/conf:/conf \ --network host \ -e ZOO_MY_ID=2 zookeeper

server03執行:

docker run -d -p 2181:2181 -p 2888:2888 -p 3888:3888 --name zookeeper_node --restart always \ -v /usr/soft/zookeeper/data:/data \ -v /usr/soft/zookeeper/datalog:/datalog \ -v /usr/soft/zookeeper/logs:/logs \ -v /usr/soft/zookeeper/conf:/conf \ --network host \ -e ZOO_MY_ID=3 zookeeper

唯一的差別是:-e ZOO_MY_ID=*而已。

其次,每臺服務上打開/usr/soft/zookeeper/conf路徑,找到zoo.cfg配置文件,修改為:

dataDir=/data dataLogDir=/datalog tickTime=2000 initLimit=5 syncLimit=2 clientPort=2181 autopurge.snapRetainCount=3 autopurge.purgeInterval=0 maxClientCnxns=60 server.1=172.192.13.10:2888:3888 server.2=172.192.13.11:2888:3888 server.3=172.192.13.12:2888:3888

然后進入其中一臺服務器,進入zk查看是否配置啟動成功:

docker exec -it zookeeper_node /bin/bash ./bin/zkServer.sh status

運行一個臨時容器,目的是為了將配置、數據、日志等信息存儲到宿主機上:

docker run --rm -d --name=temp-ch yandex/clickhouse-server

拷貝容器內的文件:

docker cp temp-ch:/etc/clickhouse-server/ /etc/ //https://www.cnblogs.com/EminemJK/p/15138536.html

//同時兼容IPV6,一勞永逸 <listen_host>0.0.0.0</listen_host> //設置時區 <timezone>Asia/Shanghai</timezone> //刪除原節點<remote_servers>的測試信息 <remote_servers incl="clickhouse_remote_servers" /> //新增,和上面的remote_servers 節點同級 <include_from>/etc/clickhouse-server/metrika.xml</include_from> //新增,和上面的remote_servers 節點同級 <zookeeper incl="zookeeper-servers" optional="true" /> //新增,和上面的remote_servers 節點同級 <macros incl="macros" optional="true" />

其他listen_host僅保留一項即可,其他listen_host則注釋掉。

cp -rf /etc/clickhouse-server/ /usr/soft/clickhouse-server/main cp -rf /etc/clickhouse-server/ /usr/soft/clickhouse-server/sub

main為主分片,sub為副本。

#拷貝配置到server02上 scp /usr/soft/clickhouse-server/main/ server02:/usr/soft/clickhouse-server/main/ scp /usr/soft/clickhouse-server/sub/ server02:/usr/soft/clickhouse-server/sub/ #拷貝配置到server03上 scp /usr/soft/clickhouse-server/main/ server03:/usr/soft/clickhouse-server/main/ scp /usr/soft/clickhouse-server/sub/ server03:/usr/soft/clickhouse-server/sub/

SCP真香。

然后就可以刪除掉臨時容器:docker rm -f temp-ch

這里三臺服務器,每臺服務器起2個CH實例,環狀相互備份,達到高可用的目的,資源充裕的情況下,可以將副本Sub實例完全獨立出來,修改配置即可,這個又是Clickhouse的好處之一,橫向擴展非常方便。

進入server1服務器,/usr/soft/clickhouse-server/sub/conf修改config.xml文件,主要修改內容:

原: <http_port>8123</http_port> <tcp_port>9000</tcp_port> <mysql_port>9004</mysql_port> <interserver_http_port>9009</interserver_http_port> 修改為: <http_port>8124</http_port> <tcp_port>9001</tcp_port> <mysql_port>9005</mysql_port> <interserver_http_port>9010</interserver_http_port>

修改的目的目的是為了和主分片main的配置區分開來,端口不能同時應用于兩個程序。server02和server03如此修改或scp命令進行分發。

server01,main主分片配置:

進入/usr/soft/clickhouse-server/main/conf文件夾內,新增metrika.xml文件(文件編碼:utf-8)。

<yandex>

<!-- CH集群配置,所有服務器都一樣 -->

<clickhouse_remote_servers>

<cluster_3s_1r>

<!-- 數據分片1 -->

<shard>

<internal_replication>true</internal_replication>

<replica>

<host>server01</host>

<port>9000</port>

<user>default</user>

<password></password>

</replica>

<replica>

<host>server03</host>

<port>9001</port>

<user>default</user>

<password></password>

</replica>

</shard>

<!-- 數據分片2 -->

<shard>

<internal_replication>true</internal_replication>

<replica>

<host>server02</host>

<port>9000</port>

<user>default</user>

<password></password>

</replica>

<replica>

<host>server01</host>

<port>9001</port>

<user>default</user>

<password></password>

</replica>

</shard>

<!-- 數據分片3 -->

<shard>

<internal_replication>true</internal_replication>

<replica>

<host>server03</host>

<port>9000</port>

<user>default</user>

<password></password>

</replica>

<replica>

<host>server02</host>

<port>9001</port>

<user>default</user>

<password></password>

</replica>

</shard>

</cluster_3s_1r>

</clickhouse_remote_servers>

<!-- zookeeper_servers所有實例配置都一樣 -->

<zookeeper-servers>

<node index="1">

<host>172.16.13.10</host>

<port>2181</port>

</node>

<node index="2">

<host>172.16.13.11</host>

<port>2181</port>

</node>

<node index="3">

<host>172.16.13.12</host>

<port>2181</port>

</node>

</zookeeper-servers>

<!-- marcos每個實例配置不一樣 -->

<macros>

<layer>01</layer>

<shard>01</shard>

<replica>cluster01-01-1</replica>

</macros>

<networks>

<ip>::/0</ip>

</networks>

<!-- 數據壓縮算法 -->

<clickhouse_compression>

<case>

<min_part_size>10000000000</min_part_size>

<min_part_size_ratio>0.01</min_part_size_ratio>

<method>lz4</method>

</case>

</clickhouse_compression>

</yandex>

<macros>節點每個服務器每個實例不同,其他節點配置一樣即可,下面僅列舉<macros>節點差異的配置。

server01,sub副本配置:

<macros>

<layer>01</layer>

<shard>02</shard>

<replica>cluster01-02-2</replica>

</macros>

server02,main主分片配置:

<macros>

<layer>01</layer>

<shard>02</shard>

<replica>cluster01-02-1</replica>

</macros>

server02,sub副本配置:

<macros>

<layer>01</layer>

<shard>03</shard>

<replica>cluster01-03-2</replica>

</macros>

server03,main主分片配置:

<macros>

<layer>01</layer>

<shard>03</shard>

<replica>cluster01-03-1</replica>

</macros>

server03,sub副本配置:

<macros>

<layer>01</layer>

<shard>02</shard>

<replica>cluster01-01-2</replica>

</macros>

至此,已經完成全部配置,其他的比如密碼等配置,可以按需增加。

在每一臺服務器上依次運行實例,zookeeper前面已經提前運行,沒有則需先運行zk集群。

運行main實例:

docker run -d --name=ch-main -p 8123:8123 -p 9000:9000 -p 9009:9009 --ulimit nofile=262144:262144 \-v /usr/soft/clickhouse-server/main/data:/var/lib/clickhouse:rw \-v /usr/soft/clickhouse-server/main/conf:/etc/clickhouse-server:rw \-v /usr/soft/clickhouse-server/main/log:/var/log/clickhouse-server:rw \ --add-host server01:172.192.13.10 \ --add-host server02:172.192.13.11 \ --add-host server03:172.192.13.12 \ --hostname server01 \ --network host \ --restart=always \ yandex/clickhouse-server

運行sub實例:

docker run -d --name=ch-sub -p 8124:8124 -p 9001:9001 -p 9010:9010 --ulimit nofile=262144:262144 \ -v /usr/soft/clickhouse-server/sub/data:/var/lib/clickhouse:rw \ -v /usr/soft/clickhouse-server/sub/conf:/etc/clickhouse-server:rw \ -v /usr/soft/clickhouse-server/sub/log:/var/log/clickhouse-server:rw \ --add-host server01:172.192.13.10 \ --add-host server02:172.192.13.11 \ --add-host server03:172.192.13.12 \ --hostname server01 \ --network host \ --restart=always \ yandex/clickhouse-server

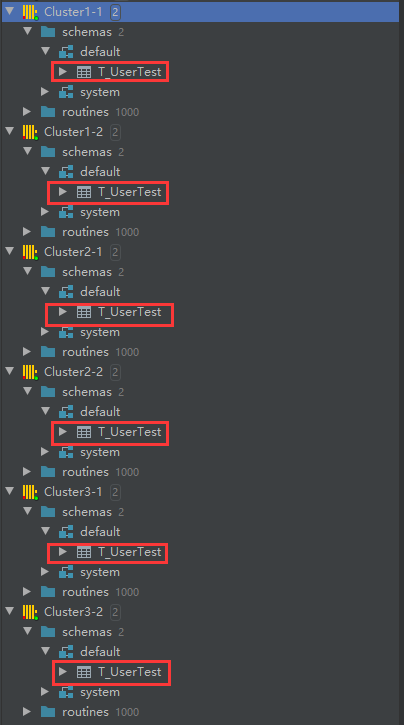

在每臺服務器執行命令,唯一不同的參數是hostname,因為我們前面已經設置了hostname來指定服務器,否則在執行select * from system.clusters查詢集群的時候,將is_local列全為0,則表示找不到本地服務,這是需要注意的地方。在每臺服務器的實例都啟動之后,這里使用正版DataGrip來打開:

在任一實例上新建一個查詢:

create table T_UserTest on cluster cluster_3s_1r

(

ts DateTime,

uid String,

biz String

)

engine = ReplicatedMergeTree('/clickhouse/tables/{layer}-{shard}/T_UserTest', '{replica}')

PARTITION BY toYYYYMMDD(ts)

ORDER BY ts

SETTINGS index_granularity = 8192;

cluster_3s_1r是前面配置的集群名稱,需一一對應上,/clickhouse/tables/是固定的前綴,相關語法可以查看官方文檔了。

刷新每個實例,即可看到全部實例中都有這張T_UserTest表,因為已經搭建zookeeper,很容易實現分布式DDL。

繼續新建Distributed分布式表:

CREATE TABLE T_UserTest_All ON CLUSTER cluster_3s_1r AS T_UserTest ENGINE = Distributed(cluster_3s_1r, default, T_UserTest, rand())

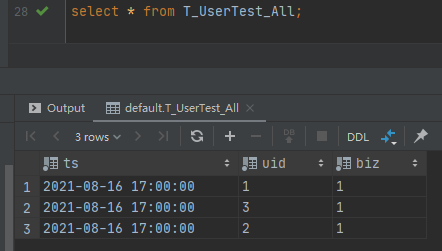

每個主分片分別插入相關信息:

--server01insert into T_UserTest values ('2021-08-16 17:00:00',1,1)

--server02

insert into T_UserTest values ('2021-08-16 17:00:00',2,1)

--server03

insert into T_UserTest values ('2021-08-16 17:00:00',3,1)

然后查詢分布式表select * from T_UserTest_All,

查詢對應的副本表或者關閉其中一臺服務器的docker實例,查詢也是不受影響,時間關系不在測試。

到此這篇關于Clickhouse Docker集群配置及部署的文章就介紹到這了,更多相關Clickhouse Docker集群內容請搜索腳本之家以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持腳本之家!