pytorch中為什么要用 zero_grad() 將梯度清零

調(diào)用backward()函數(shù)之前都要將梯度清零,因?yàn)槿绻荻炔磺辶悖琾ytorch中會(huì)將上次計(jì)算的梯度和本次計(jì)算的梯度累加。

這樣邏輯的好處是,當(dāng)我們的硬件限制不能使用更大的bachsize時(shí),使用多次計(jì)算較小的bachsize的梯度平均值來(lái)代替,更方便,壞處當(dāng)然是每次都要清零梯度。

optimizer.zero_grad()

output = net(input)

loss = loss_f(output, target)

loss.backward()

補(bǔ)充:Pytorch 為什么每一輪batch需要設(shè)置optimizer.zero_grad

CSDN上有人寫(xiě)過(guò)原因,但是其實(shí)寫(xiě)得繁瑣了。

根據(jù)pytorch中的backward()函數(shù)的計(jì)算,當(dāng)網(wǎng)絡(luò)參量進(jìn)行反饋時(shí),梯度是被積累的而不是被替換掉;但是在每一個(gè)batch時(shí)毫無(wú)疑問(wèn)并不需要將兩個(gè)batch的梯度混合起來(lái)累積,因此這里就需要每個(gè)batch設(shè)置一遍zero_grad 了。

其實(shí)這里還可以補(bǔ)充的一點(diǎn)是,如果不是每一個(gè)batch就清除掉原有的梯度,而是比如說(shuō)兩個(gè)batch再清除掉梯度,這是一種變相提高batch_size的方法,對(duì)于計(jì)算機(jī)硬件不行,但是batch_size可能需要設(shè)高的領(lǐng)域比較適合,比如目標(biāo)檢測(cè)模型的訓(xùn)練。

關(guān)于這一點(diǎn)可以參考這里

關(guān)于backward()的計(jì)算可以參考這里

補(bǔ)充:pytorch 踩坑筆記之w.grad.data.zero_()

在使用pytorch實(shí)現(xiàn)多項(xiàng)線性回歸中,在grad更新時(shí),每一次運(yùn)算后都需要將上一次的梯度記錄清空,運(yùn)用如下方法:

w.grad.data.zero_()

b.grad.data.zero_()

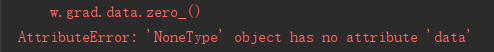

但是,運(yùn)行程序就會(huì)報(bào)如下錯(cuò)誤:

報(bào)錯(cuò),grad沒(méi)有data這個(gè)屬性,

原因是,在系統(tǒng)將w的grad值初始化為none,第一次求梯度計(jì)算是在none值上進(jìn)行報(bào)錯(cuò),自然會(huì)沒(méi)有data屬性

修改方法:添加一個(gè)判斷語(yǔ)句,從第二次循環(huán)開(kāi)始執(zhí)行求導(dǎo)運(yùn)算

for i in range(100):

y_pred = multi_linear(x_train)

loss = getloss(y_pred,y_train)

if i != 0:

w.grad.data.zero_()

b.grad.data.zero_()

loss.backward()

w.data = w.data - 0.001 * w.grad.data

b.data = b.data - 0.001 * b.grad.data

以上為個(gè)人經(jīng)驗(yàn),希望能給大家一個(gè)參考,也希望大家多多支持腳本之家。

您可能感興趣的文章:- PyTorch梯度裁剪避免訓(xùn)練loss nan的操作

- Pytorch訓(xùn)練過(guò)程出現(xiàn)nan的解決方式

- pytorch 權(quán)重weight 與 梯度grad 可視化操作

- PyTorch 如何檢查模型梯度是否可導(dǎo)

- PyTorch 如何自動(dòng)計(jì)算梯度

- pytorch 梯度NAN異常值的解決方案